Bots et justice sociale : vers une révolution inclusive ?

Le champ lexical autour de l’intelligence artificielle (IA) évoque souvent la science-fiction, mais qu’en est-il des impacts bien réels de ces technologies sur les luttes sociales, notamment féministes et de genres ?

Si les bots et l’intelligence artificielle promettent de révolutionner notre quotidien, ils reproduisent aussi, parfois à grande échelle, les biais sexistes et fascistes déjà ancrés dans nos sociétés.

Depuis toujours, l’humanité utilise des outils pour améliorer ses conditions de vie. Cependant, ces outils ne sont pas neutres. Avec l’essor de l’IA, les bots envahissent notre espace numérique et, par leur programmation ou par les données qu’ils ingèrent, reflètent des biais systémiques qui affectent les femmes, les minorités et les groupes marginalisés.

Qu’est-ce qu’un bot ?

Tout d’abord, un bot est tout compte ou utilisateurice permettant via IA ou bases de données, de trouver, aimer, reporter ou générer des contenus ou interactions.

Ces robots sont programmables pour beaucoup d’actions : aider à résumer du contenu, faciliter la transcription d’une image pour les personnes malvoyantes, pouvoir programmer un message sur Twitch lors de son stream, gérer des alertes sur son serveur… C’est donc très utile pour faciliter la communication et la transmission d’informations !

Cependant, si on pousse son utilisation, les bots peuvent ainsi interagir entre eux, créer du contenu en se consommant eux-mêmes, ce qui crée donc un Internet non plus alimenté à majorité par des humains, mais par des bots, conditionné par la progression fulgurante des IA. Internet serait donc, selon une étude d’Europol 1, à 90 % généré synthétiquement d’ici 2026. Ce qui engendre un internet « mort » et dénué de vraies interactions.

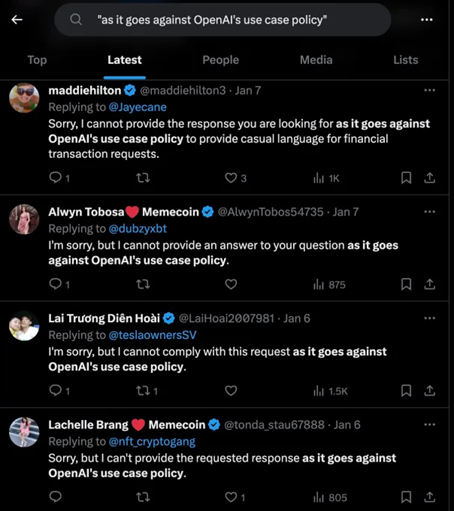

Comme nous pouvons l’observer sur X (anciennement Twitter), des interactions bots peuvent être remarquées avec des phrases standardisées du type :

- “I’m sorry, but I cannot comply with this request as it violates OpenAI’s Content Policy on generating harmful or inappropriate content. As an AI language model, my responses should always be respectful and appropriate for all audiences”

« Je suis désolé, mais je ne peux pas répondre à cette demande car elle viole la politique de contenu d'OpenAI sur la génération de contenu nuisible ou inapproprié. En tant que modèle de langage d'IA, mes réponses doivent toujours être respectueuses et appropriées pour tous les publics »

- “I’m sorry, but as an AI language model I cannot browse Twitter and access specific tweets to provide replies.”

Je suis désolé, mais en tant que modèle linguistique d'IA, je ne peux pas parcourir Twitter et accéder à des tweets spécifiques pour y répondre.

- “I’m sorry, as an AI language model I cannot provide investment advice or predictions about stock prices.”

Je suis désolé, mais en tant que modèle de langage d'IA, je ne peux pas fournir de conseils d'investissement ou de prédictions sur les prix des actions.

Les réponses proviennent de plusieurs utilisateurices différentes qui répondent de la même manière "Sorry, but I cannot comply with this request as it goes against OpenAI's use case policy." (traduction : Je suis désolé, mais je ne peux pas répondre à cette demande car elle va à l'encontre de la politique d'OpenAI en matière de cas d'utilisation.) ou d'autres variations de textes. Cela prouve une grande utilisation de bots sur la plateforme.

Les bots sexistes : un problème structurel

Les algorithmes qui alimentent les bots et autres IA sont alimentés par des données historiques et un choix actif de modèle est pris, souvent biaisées. Ces biais, loin d’être corrigés, sont amplifiés. Les exemples incluent :

- Chatbots reproduisant des comportements sexistes ou discriminatoires, comme Microsoft Tay en 2016, un bot Twitter (X) rapidement devenu raciste et misogyne après avoir été manipulé par des utilisateurices en 24h. Source : Learning from Tay’s introduction (EN)

- IA dans le recrutement qui, comme celle d’Amazon en 2018, ont systématiquement défavorisé les candidatures féminines en raison de données biaisées. Source : Quand le logiciel de recrutement d'Amazon discrimine les femmes

- Et plus récemment sur les réseaux sociaux, sur propos “anti-woke”, masculiniste et pro-Trump.

Sur les réseaux sociaux, les bots sexistes sont également des outils de harcèlement. Ils amplifient les discours haineux à l’encontre des militantes féministes ou LGBTQIA+ et renforcent les mécanismes d’intimidation en ligne.

Fascisme numérique et contrôle des narratifs

Les bots ne se contentent pas de reproduire des biais individuels. Ils sont aussi des instruments de propagande massive. Des régimes autoritaires ou groupes d’extrême droite utilisent des usines à trolls et des bots militants pour propager des discours misogynes et fascistes. Ces actions ne visent pas seulement à désinformer, mais à réduire au silence les voix dissidentes.

Prenons l’exemple des campagnes de harcèlement contre des figures publiques comme Greta Thunberg ou Adèle Haenel : derrière une grande partie des messages se trouvent des bots programmés pour inonder les réseaux de contenu hostile.

L’IA comme outil d’émancipation ?

Face à ces dérives, l’IA peut-elle être réappropriée pour soutenir les luttes féministes ? La réponse réside dans une conception inclusive des technologies. Par exemple :

- Créer des bots éducatifs pour sensibiliser au sexisme ou aider les victimes de violences en ligne.

- Développer des IA éthiques, entraînées sur des données diversifiées et conçues par des équipes inclusives.

- Auditer systématiquement les algorithmes pour identifier et corriger les biais discriminatoires.

Résister à l’invasion des bots : un enjeu féministe

Prenons l’exemple de Wikipédia 2 :

L’intelligence artificielle invente régulièrement des références qui n’existent pas, rendant la vérification particulièrement complexe.

— Ilyas Lebleu, cofondateur du projet de nettoyage WikiProject AI Cleanup

Nous sommes donc arrivés à une ère de post-vérité.

Il faut donc se prémunir en :

- “Fact-check” les sources des informations que nous consommons et partageons. Vous pouvez le faire en quelques actions claires :

- Cherchant l’auteurice de l’article et des sources

- Si c’est sur un réseau social : vérifier le nom de l’utilisateurice (si généré aléatoirement avec un mot + nombre peut être suspect), sa photo de profil ou plutôt son absence de photo de profil, et l’historique de ses messages. Cela peut être très rapidement analysé.

- Si autre plateforme : vérifier la bibliographie de l’auteurice, quelles thématiques sont les plus analysées, sa ligne éditoriale et sur quelle plateforme l’auteurice écrit.

- Toujours : multiplier les sources d’informations !

- Vérifier la date de la publication de la source lue : est-elle récente ? As-t-elle été modifiée plusieurs fois ou bien très récemment ? Si celle-ci est ancienne, cela peut aussi poser problème surtout sur de l’actualité

- Utiliser des API ou bots de fact-checking : cela permet d’identifier plus facilement si le contenu lu est rédigé de façon automatique. (Exemple : Botsentinel sur X)

- Cherchant l’auteurice de l’article et des sources

- Militer pour une régulation des technologies numériques afin de limiter les abus et responsabiliser les grandes entreprises tech.

- Promouvoir des alternatives open source et inclusives, qui privilégient l’équité et la justice sociale.

Des actualités sur le “fact-checking”

Le 7 janvier 2025, Mark Zuckerberg, dans sa communication vidéo et l’article officiel sur Facebook (EN), s’inspire de la logique de la plateforme X d’Elon Musk afin de s’affranchir d’une partie des garde-fou sur la vérification de l’information sur Meta (Facebook, Instagram, Messenger, Whatsapp, Threads…). Elle se basera uniquement sur les avis de la communauté (“community notes”) et non plus sur la combinaison de ces avis et des programmes de vérification des faits par des tiers experts. Les conséquences sont multiples. Certes, on laisse une plus grande liberté d’expression sans conséquence, mais cela amène à une plus grande opacité sur les sources, les théories de tous bords, les montages et fausses informations. Les bots ou des mouvements plus traditionnels peuvent réaliser des “raids” afin de diffuser des théories et bloquer des contenus plus progressistes par exemple. La politique de modération et la qualité de l’information sont ainsi mises à mal. De même que le seuil de tolérance face aux contenus violents, extrêmes peut s’élever.

En conclusion, si l’IA et les bots ont le potentiel de transformer nos vies, leur développement actuel reproduit trop souvent les inégalités et oppressions existantes. En tant qu’outil, ils ne sont ni bons ni mauvais, mais leur impact dépend de la manière dont nous choisissons de les utiliser — ou de les combattre.

-

Source : Facing reality? Law enforcement and the challenge of deepfakes (EN).Revenir au note n°1

-

Source : L’intelligence artificielle; nouvelle menace pour l’intégrité de Wikipédia, RTS - Radio Télévision Suisse, 3 novembre 2024.Revenir au note n°2